مدل هوش مصنوعی جدید GPT-4 تغییرات مهمی داشته است و در این مطلب پنج مورد از مهمترین آنها را بررسی میکنیم.

مدل هوش مصنوعی جدید GPT-4 که دیشب توسط OpenAI معرفی شد، تغییرات مهمی نسبت به نسخه قبلی دارد و سروصدای زیادی بهپا کرده است. در این مطلب میخواهیم ببینیم مهمترین تفاوتهای این نسخه با GPT-3 چیست.

پیش از هر چیز باید اشارهای به نام GPT-4 داشته باشیم. OpenAI چندی قبل مدل هوش مصنوعی خود را به مایکروسافت داد تا از آن در چتبات بینگ استفاده کند. البته این مدل ظاهراً تفاوتهایی با مدل حاضر در ChatGPT داشت و از آن با عنوان GPT-3.5 یاد میشد. اما حالا بالاخره نوبت به GPT-4 رسیده و مایکروسافت هم از همین مدل در بینگ چت استفاده کرده است.

1. GPT-4 میتواند تصاویر را درک کند

مشهودترین تغییر در نسخه جدید مدل هوش مصنوعی GPT-4 چندوجهیبودن آن است؛ یعنی میتواند بیش از یک نوع محتوا را درک کند. GPT-3 محدود به متن بود، اما وارث آن میتواند تصاویر را نگاه کند و اطلاعات آن را بفهمد.

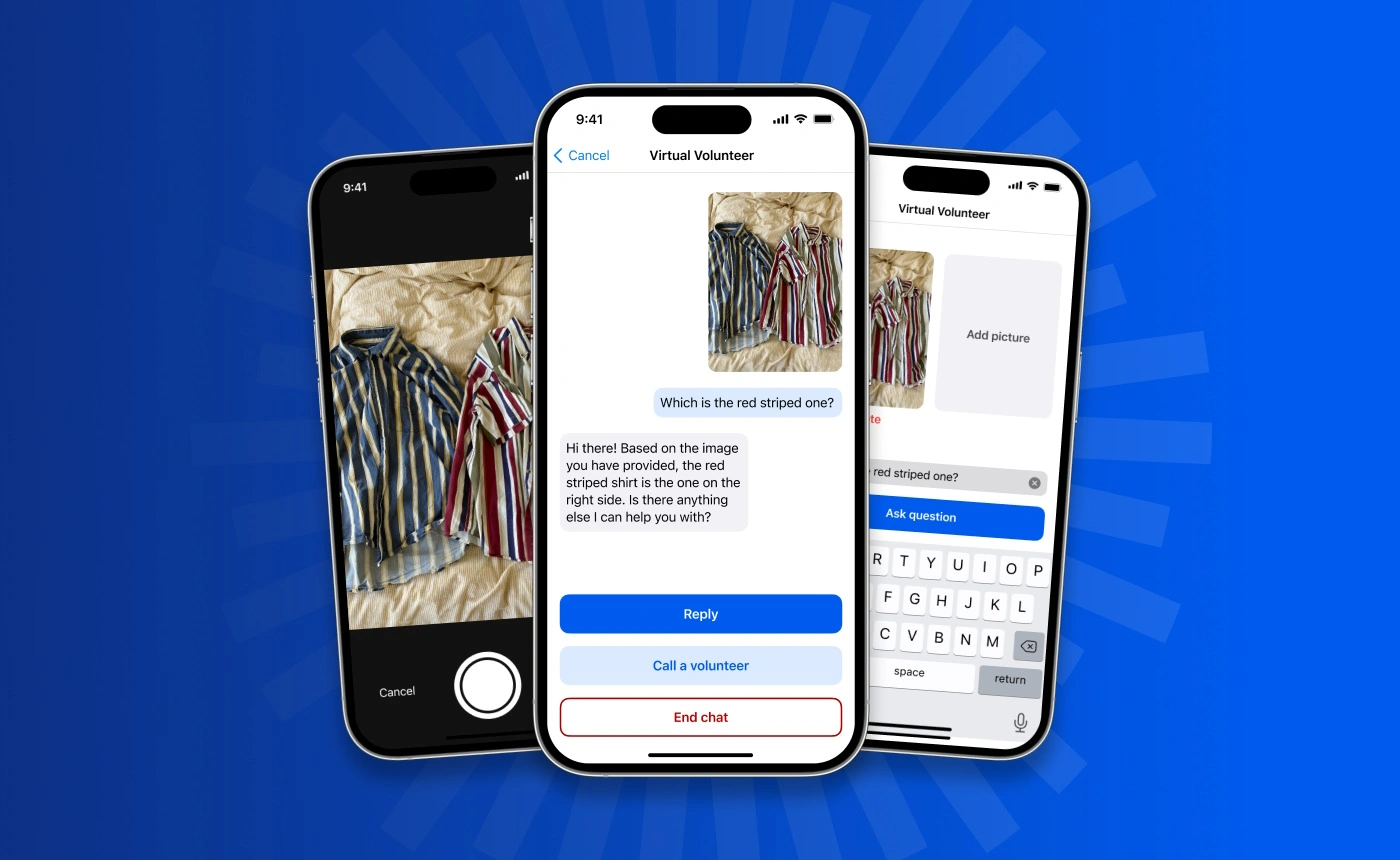

Be My Eyes

برای مثال میتوانید از GPT-4 بخواهید آنچه درون تصاویر وجود دارد را توصیف کند یا براساس آن به شما اطلاعات دهد. OpenAI حالا با اپلیکیشن Be My Eyes همکاری کرده است تا از این ویژگی برای کمک به افراد نابینا یا کمبینا استفاده کند. برای نمونه جیپیتی-4 میتواند الگوهای روی لباسها را ببیند، گیاهان مختلف را تشخیص دهد یا برچسب روی محصولات را بخواند و نوشته آنها را ترجمه کند.